科技賦能 運用先進數據處理技術,正確分析數據以提升公司效率

在當今數據驅動的商業環境中,數據已成為企業的核心資產。正確分析數據并利用先進的數據處理技術,是提升公司運營效率、優化決策、驅動創新的關鍵。本文旨在探討如何構建科學的數據分析流程,并闡述相關數據處理技術開發的重要性與實踐路徑。

一、 建立正確的數據分析思維與流程

正確的數據分析始于明確的目標和科學的流程,而非簡單的工具堆砌。

- 目標導向與問題定義:分析的首要步驟是明確業務目標。是希望提升生產效率、降低運營成本、優化客戶體驗,還是發現新的市場機會?清晰的問題定義是確保分析工作不偏離軌道的基石。

- 數據收集與整合:確保數據來源的可靠性、一致性和完整性。這需要打破部門數據孤島,整合來自生產、銷售、財務、客戶服務等多渠道的結構化與非結構化數據,形成統一的數據視圖。

- 數據清洗與預處理:原始數據往往包含噪聲、缺失值和異常值。通過數據清洗、轉換和歸一化等預處理步驟,為后續分析提供高質量的數據基礎,這是保證分析結果準確性的關鍵環節。

- 探索性分析與建模:運用統計分析、可視化工具探索數據內在規律。基于業務問題,選擇合適的分析模型(如描述性分析、預測性分析或規范性分析)進行深入挖掘。

- 解讀結果與行動洞察:分析的價值在于產生可執行的洞察。分析師需將數據結果轉化為通俗易懂的業務語言,明確“數據告訴我們什么”以及“我們應該做什么”,推動決策與行動。

- 持續監控與迭代優化:建立數據指標體系,持續監控關鍵績效指標(KPIs)的變化,并根據業務反饋和新的數據,不斷迭代優化分析模型與策略。

二、 關鍵技術開發:數據處理技術的核心支柱

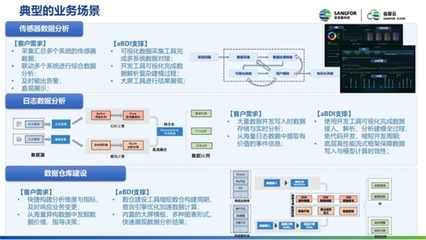

高效、準確的數據分析離不開底層強大的數據處理技術支撐。相關技術開發正朝著實時化、智能化、平臺化方向發展。

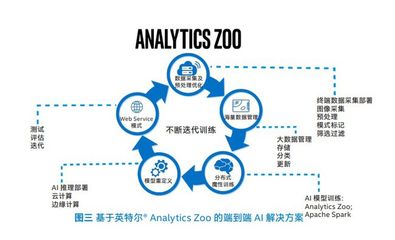

- 大數據處理框架:如Apache Hadoop、Spark等分布式計算框架,能夠處理海量、高速、多樣的數據,為大規模數據分析提供算力基礎。開發重點在于優化資源調度、提升計算效率與降低成本。

- 實時流處理技術:對于需要即時響應的場景(如欺詐檢測、實時推薦),Flink、Kafka Streams等技術實現了數據的實時攝入、處理與分析,極大縮短了從數據到決策的周期,直接提升運營響應效率。

- 云原生與數據湖倉:基于云平臺(如AWS, Azure, GCP)的數據湖和數據倉庫解決方案,提供了彈性、可擴展的存儲與計算能力。技術開發聚焦于實現湖倉一體,兼顧數據湖的靈活性與數據倉庫的管理規范性,簡化數據架構。

- 人工智能與機器學習集成:將機器學習算法(如預測模型、聚類分析、自然語言處理)深度集成到數據處理流水線中,實現自動化洞察與智能決策。AutoML等技術正在降低模型開發與應用的門檻。

- 數據治理與安全技術:在分析效率的必須保障數據質量、安全與合規。相關技術包括數據血緣追蹤、元數據管理、隱私計算(如聯邦學習)、差分隱私等,確保數據在可控、可信的環境下被使用。

- 低代碼/無代碼與自助式分析平臺:通過開發用戶友好的可視化數據分析工具和平臺(如Tableau, Power BI的深度定制化),賦能業務人員自主進行探索性分析,減少對專業數據團隊的依賴,加速分析民主化進程。

三、 融合實踐:以技術驅動效率提升

將正確的分析流程與先進的技術相結合,方能最大化數據價值。

公司應構建一個從數據源到業務價值實現的閉環體系。例如,利用流處理技術實時監控生產線傳感器數據,通過實時分析預測設備故障(預測性維護),并自動觸發維修工單,從而減少停機時間,提升生產效率。通過整合客戶交互數據,利用機器學習模型進行客戶分群與需求預測,指導精準營銷和產品開發,提升市場效率。

結論

確保公司效率的數據分析,是一個將科學方法論與前沿技術深度融合的系統工程。它不僅要求企業樹立數據驅動的文化,建立嚴謹的分析流程,更要求持續投入數據處理技術的研發與應用,構建敏捷、智能、安全的數據基礎設施。唯有如此,企業才能在數據的洪流中捕捉真知,將數據潛能轉化為實實在在的運營效率與競爭優勢。

如若轉載,請注明出處:http://www.beijingportal.com.cn/product/51.html

更新時間:2026-01-05 08:48:39