八款主流數據遷移工具技術選型解析,助力數據處理技術開發

在當今數據驅動的時代,數據遷移工具的選擇直接影響著數據處理項目的效率與質量。無論是系統重構、數據整合還是云上遷移,選對工具能事半功倍。本文將深入解析八款主流數據遷移工具,為技術開發人員提供全面的技術選型參考。

1. Apache NiFi

Apache NiFi是一款強大的數據集成平臺,專注于數據流自動化。其圖形化界面讓用戶能直觀設計數據流,支持從多種數據源實時捕獲、轉換和路由數據。NiFi內置了豐富的處理器,涵蓋數據格式轉換、加密、壓縮等場景。在技術選型中,NiFi適合需要復雜數據流編排、實時處理且對可視化操作有高要求的團隊。

2. AWS Data Pipeline

作為亞馬遜云服務的數據編排工具,AWS Data Pipeline專為AWS生態設計。它支持定期調度數據遷移任務,能無縫集成S3、RDS、DynamoDB等服務。對于已全面擁抱AWS云服務的企業,此工具能極大簡化跨服務數據搬運流程,但其鎖定在AWS生態內,跨云部署能力有限。

3. Talend

Talend提供開源和企業版的數據集成方案,以其強大的ETL(提取、轉換、加載)功能著稱。它支持超過900種連接器,涵蓋數據庫、SaaS應用、大數據平臺等。Talend Studio提供可視化設計環境,生成的代碼可部署到本地或云環境。在需要處理復雜數據轉換且追求高可擴展性的項目中,Talend是優秀選擇。

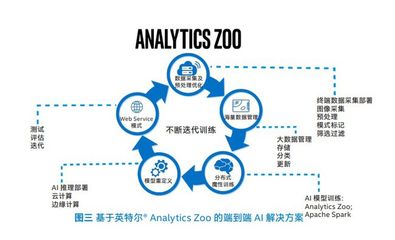

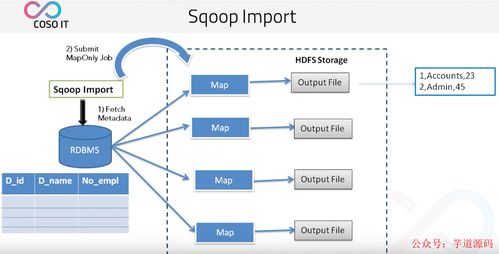

4. Apache Sqoop

專為Hadoop生態設計,Apache Sqoop能在關系型數據庫(如MySQL、Oracle)與Hadoop(HDFS、Hive、HBase)之間高效傳輸批量數據。其命令行界面簡潔,適合已有Hadoop技術棧且主要進行結構化數據遷移的場景。不過,Sqoop對非關系型數據庫支持有限,且更側重批量而非實時遷移。

5. Google Cloud Dataflow

基于Apache Beam模型,Google Cloud Dataflow提供全托管的數據處理服務,支持批處理和流處理。其統一編程模型讓開發者能編寫一次代碼,在批量和實時場景中運行。對于追求彈性伸縮、希望簡化基礎設施管理的團隊,Dataflow能有效降低運維負擔,尤其適合已使用Google Cloud Platform的企業。

6. Apache Kafka Connect

作為Apache Kafka生態系統的一部分,Kafka Connect專注于在Kafka和外部系統之間構建可擴展、可靠的數據管道。它提供大量現成連接器,支持分布式部署和故障恢復。在需要構建實時數據管道、強調低延遲和高吞吐量的場景中,Kafka Connect是理想選擇,尤其適合已有Kafka作為數據中樞的架構。

7. Azure Data Factory

微軟Azure的云數據集成服務,提供無代碼界面和代碼編輯兩種模式。它能協調跨本地和云環境的數據移動,內置了數據流功能,支持視覺化設計數據轉換邏輯。對于深度使用微軟技術棧(如SQL Server、Power BI)的企業,Azure Data Factory能實現無縫集成,提供端到端的數據解決方案。

8. Hevo Data

作為新興的SaaS數據管道平臺,Hevo Data主打零代碼和分鐘級部署。它提供150多種預建連接器,支持自動模式檢測和數據類型映射。Hevo適合需要快速搭建數據管道、缺乏專門數據工程團隊的中小企業,但其定制化能力和對復雜場景的支持相對有限。

技術選型建議

選擇數據遷移工具時,需綜合考慮以下因素:

- 數據源與目標:評估工具對現有及未來數據系統的支持度。

- 處理模式:明確需求是批量、實時還是混合模式。

- 技術棧兼容性:確保工具與現有基礎設施和團隊技能匹配。

- 成本與許可:平衡開源工具的靈活性與商業工具的服務支持。

- 可擴展性:考量數據量增長和未來業務變化的需求。

數據處理技術的開發趨勢正朝著自動化、實時化和云原生方向發展。掌握這些工具的特性,結合具體業務場景,才能做出明智的技術選型,真正實現“yyds”(永遠的神)級別的數據處理效能。在實踐中,往往需要組合使用多種工具,構建端到端的數據管道,以應對日益復雜的數據生態挑戰。

如若轉載,請注明出處:http://www.beijingportal.com.cn/product/52.html

更新時間:2026-01-05 09:50:08